Journal influence

Bookmark

Next issue

Extrinsic calibration of the omnidirectional vision system and 3D reconstruction of an indoor environment

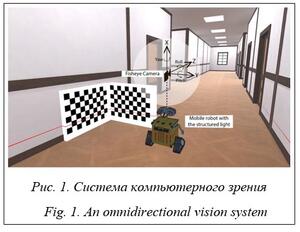

Abstract:Autonomous navigation of mobile robots indoors has attracted the attention of many computer vision researchers over the years. A wide variety of approaches and algorithms were proposed to solve this problem. The proper perception of the environment becomes an important part for such robots. Robots must be able to evaluate the three-dimensional structure of the environment in order to perform their algorithms. However, visual sensors, such as conventional cameras, do not allow processing enough information due to the limited viewing angle. This article presents a comprehensive approach for three-dimensional modeling of an indoor environment. The vision system considered in this paper consists of an omnidirectional camera and a structured light. The omnidirectional camera captures a wide range of information, while the laser beam is easy to detect and extract for further analysis. To obtain reliable measurement results, the vision system must be calibrated. For this purpose, the paper considers an improved method of external calibration. The paper also considers the 3D reconstruction algorithm of an indoor environment that includes a semantic segmentation neural network. A single input image is required to perform the calibration method as well as the 3D modeling method. These methods significantly speed up the data processing process, without losing accuracy in measurements. In turn, recent advances in neural networks require a large amount of training data in environments with different conditions. Thus, developing and testing navigation algorithms can be expensive and time-consuming. This article evaluates the proposed methods experimentally using data generated by a previously developed simulator.

Аннотация:Автономная навигация мобильных роботов внутри помещения привлекает внимание исследователей компьютерного зрения уже многие годы. Для решения данной задачи предложены разнообразные подходы и алгоритмы. Для выполнения заложенных в роботах алгоритмов они должны уметь оценивать трехмерную структуру окружающей среды. Однако визуальные датчики, такие как обычные камеры, не позволяют получать достаточное количество информации из-за ограниченного угла обзора. Авторы данного исследования предлагают комплексный подход для трехмерного моделирования внутренней среды. Система компьютерного зрения, рассматриваемая в работе, состоит из всенаправленной камеры и источника структурированного света. Всенаправленная камера обеспечивает широкий спектр информации, в то время как лазерный луч легко обнаружить и извлечь для дальнейшего анализа. Для получения достоверных результатов измерений система должна быть откалибрована. С этой целью предлагается усовершенствованный метод внешней калибровки. Рассматривается реконструкция внутренней среды помещения на базе аналогичной системы компьютерного зрения, а также алгоритма, включающего в свой состав нейронную сеть семантической сегментации. Для выполнения алгоритмов методов калибровки и трехмерного моделирования требуется одно входное изображение. Предложенные методы в значительной степени ускоряют процесс обработки данных без потери точности в измерениях. Их экспериментальная оценка осуществлялась с помощью данных, генерируемых посредством разработанного авторами ранее симулятора.

| Authors: Kholodilin, I.Yu. (kholodilin.ivan@yandex.ru ) - South Ural State University (National Research University) (Postgraduate Student), Chelyabinsk, Russia | |

| Keywords: 3D reconstruction, extrinsic calibration, semantic data, structured light, omnidirectional camera, virtual environment |

|

| Page views: 990 |

PDF version article |

Данное исследование обусловлено широким использованием всенаправленной камеры и структурированного света в качестве источников получения информации из окружающей среды. Например, картографирование или реконструкция помещения и навигация мобильных роботов – это потенциальные приложения. Использование всенаправленной камеры дает широкий угол обзора, что является преимуществом в сравнении со стандартными камерами. В силу высокого искажения изображений может вызвать затруднения извлечение одинаковых пикселей между ними в случае со стереозрением. Более того, условия окружающей среды способны выводить из строя алгоритмы стереозрения, например, условия освещенности. Решение может быть найдено путем интеграции структурированного света в систему. Основным преимуществом использования структурированного света для анализа данных является его простой механизм обнаружения и извлечения из исходного изображения. Таким образом, система компьютерного зрения, состоящая из всенаправленной камеры в сочетании со структурированным светом, вызывает большой интерес среди ученых благодаря широкому углу обзора и высокой эффективности измерений. Для получения достоверных измерений система компьютерного зрения нуждается в калибровке. Это обусловлено тем, что без известной связи между камерой и лазерной плоскостью невозможно провести измерения соответствующим образом. Данное утверждение можно обосновать, проанализировав несколько существующих исследований. В работе [1] авторы проводили эксперименты с определенными допущениями, а именно: камера и лазерная плоскость были установлены параллельно полу. Экспериментальные данные оказались не такими точными, как ожидалось. Следует отметить, что даже небольшие перекосы могут привести к неправильным измерениям, что особенно важно для всенаправленной системы зрения, характеризующейся широким углом обзора. В данной статье авторы рассматривают модель системы компьютерного зрения, включающую в свой состав всенаправленную камеру и источник структурированного света, а также калибровку системы и дальнейшую оценку качества калибровочных параметров посредством построения 2D- и 3D-карт помещения. Отличительной особенностью данных методов является то, что можно произвести калибровку системы и извлечь 2D- и 3D-информацию о помещении за счет одного изображения. Эксперименты проводились на базе разработанного ранее симулятора iLabit OmViSys [2, 3, https://ilabit4.wixsite.com/mysite-1]. Методы и решения Внешняя калибровка системы компьютерного зрения. В исследованиях других авторов представлены различные способы калибровки, такие как метод, основанный на использовании куба в качестве мишени, калибровка с применением шара [4], геометрический метод калибровки, основанный на параллельных линиях [5]. Наиболее популярно использование шахматного шаблона [6–8]. Для калибровки лазерной плоскости требуются, по меньшей мере, три неколлинеарные точки. Решение может быть получено путем анализа извлеченных лазерных точек, принадлежащих шаблону шахматной доски, размещенному в разных положениях. Аналогичная методика калибровки принята для системы всенаправленного зрения в работе [6]. Вместо перемещения шаблона в другое положение авторы использовали альтернативное решение, основанное на базе двух перпендикулярных шахматных фигур. Однако для взаимоотношений между лазерной плоскостью и камерой по шахматным шаблонам требуются дополнительные шаги, усложняющие процесс калибровки. Для каждой позиции шаблона должны быть сделаны два снимка – один с лазерным лучом (для извлечения луча) и другой без него (для извлечения точек шаблона). В случае с одним изображением (лазерный луч присутствует на изображении) точки шаблона могут быть извлечены неверно из-за принадлежности к нему лазерных точек, поэтому для получения достоверных результатов измерений необходимо внедрить новые шаблоны и методы калибровки, упрощающие процесс получения параметров. Реконструкция помещения. Специалистам известны многочисленные методы реконструкции внутренней среды помещения. Общепринятым подходом к созданию цифрового представления сцены является генерация 3D-облака точек по нескольким цифровым изображениям [9]. Эффективность методов зависит от того, насколько хорошо текстурирована окружающая среда. В связи с популяризацией RGBD-камер были предложены несколь-ко методов моделирования сцен посредством Microsoft Kinect [10, 11]. Однако Kinect имеет некоторые недостатки, один из главных – ограниченный угол обзора. В статье [12] была предложена система, состоящая из нескольких сенсоров Kinect и зеркальных камер. Путем слияния изображений RGB и RGBD авторы смогли расширить угол обзора для реконструкции окружающей среды, но слепые зоны все еще присутствуют. Эта проблема может быть решена путем интеграции в систему еще большего количества Kinect-сенсоров, но это ведет к увеличению количества вычислительных операций и стоимости системы. Для достижения широкого горизонтального угла обзора с большой дальностью действия и высокой точностью измерений несколько Kinect могут быть заменены на один лидар [9]. Меньшее количество элементов делает систему более надежной, но все же одного лидара недостаточно для анализа сцены в вертикальном направлении. В то же время системы, включающие в свой состав несколько лидаров, оказывают значительное влияние на стоимость, размер и вес системы. Несколько подходов, основанных на использовании одного лидара, позволили решить эту проблему [12, 13], обеспечив экономичную систему и достижение широкого вертикального угла обзора. Общая идея этих работ заключается в переходе от жестких систем к более гибким конфигурациям, вращая лидар. Однако данные системы остаются довольно дорогостоящими для применения в закрытых помещениях. Более экономичное и менее габаритное решение может быть достигнуто за счет использования структурированного света. В статье [14] рассматривался малогабаритный датчик размером с ладонь, состоящий из всенаправленной камеры, структурированного света и вращающегося двигателя. При вращательном движении извлекаются координаты лазера для построения 3D-модели помещения. В данной ситуации особое внимание должно быть уделено типу используемого энкодера, поскольку, например, магнитные энкодеры могут страдать от проблем нелинейности, что может отрицательно сказаться на конечных измерениях. В работе [15] рассматривалась система, основанная на поворотной платформе. Обеспечив точный контроль угловой скорости, авторы добились высокой точности всенаправленной реконструкции. Однако данный тип зрительной системы имеет относительно габаритную и сложную структуру, которую трудно воссо-здать без специального оборудования. Кроме того, методы, предлагаемые в [14, 15], предоставляют 3D-модель помещения без текстур. Даже если заниматься модернизацией данных программ, процесс построения модели будет затратным по времени, так как за счет поворота лазерной плоскости необходимо получить 3D-модель всего помещения. Чтобы сократить время реконструкции, необходимо рассмотреть другие методы. В последние годы прогресс в обучении нейронных сетей коснулся и исследований, направленных на реконструкцию структуры внутренних сцен [16, 17]. Основное преимущество предлагаемых методов заключается в том, что они позволяют получить 3D-макет внутренней сцены по одному изображению, захваченному всенаправленной камерой. Основным недостатком данных методов является то, что они не способны восстанавливать реальные размеры помещений. Таким образом, для исследователей до сих пор актуальна проблема создания надежного метода цифрового представления внутренней среды с меньшим количеством входных данных. Метод калибровки

Опираясь на модель камеры, описанную в работе [18], уравнение проекции лазерной плоскости можно записать следующим образом:

где u, v – координаты пикселей изображения; r1c, r2c, r3c – векторы матрицы поворота камеры; r1l, r2l, r3l, tl – параметры, представляющие матрицу перехода лазерной плоскости; f(p) – полином, который может быть расписан как

где ai – коэффициенты; N – степень полинома; uc, vc – координаты центра изображения. Лазерная плоскость расположена на фиксированном расстоянии от оптического центра камеры (на рисунке 1 вдоль оси X). Данное расстояние соответствует первой строке вектора tl, следовательно, глобальные координаты вдоль оси X не изменяются. Таким образом, в (1) X = 0, и это уравнение можно преобразовать:

Калибровка системы. Процедура внешней калибровки заключается в нахождении матрицы поворота камеры и матрицы перехода лазерной плоскости. Эти параметры можно найти, решив задачу оптимизации:

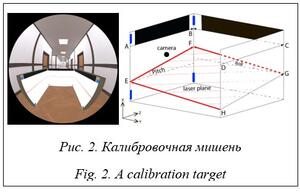

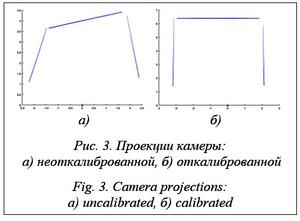

Для решения задачи была разработана калибровочная мишень (рис. 2). Она позволяет выполнять внешнюю калибровку посредством одного изображения.

Параметр yaw рассчитывается путем перемножения угловых коэффициентов векторов AB и DC. Эти векторы зависят от yaw, тогда как pitch, полученный на предыдущем этапе, постоянен. Формулировка выглядит следующим образом:

При известных pitch и yaw можно рассчитать параметр roll. Он может быть найден путем минимизации углового коэффициента вектора CB, тогда как pitch и yaw, полученные на предыдущих этапах, постоянны. Эту задачу минимизации можно записать следующим образом:

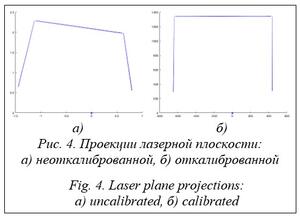

Матрица перехода лазерной плоскости. Опишем процесс получения параметров, образующих матрицу перехода [Rl|Tl] лазерной плоскости, являющихся частью уравнения (5), при известных параметрах Rc. Сначала извлеченные из изображения координаты лазерного луча, принадлежащие сторонам мишени, проецируются при помощи уравнения (4) (рис. 4а). После этого для каждого параметра матрицы перехода задачи минимизации могут быть описаны серией приведенных далее уравнений. Как и ранее, pitch может быть найден, делая проецируемые векторы EF и HG коллинеарными друг другу. Формулировка имеет следующий вид:

Еще одним параметром, связанным с Rl, является roll. Он может быть найден путем минимизации углового коэффициента вектора GF. Эту задачу минимизации можно записать следующим образом:

Как только параметры Rl будут известны, можно вычислить расстояние между камерой и лазерной плоскостью, которое является частью матрицы Tl. Реальное расстояние D1 между левой и правой сторонами мишени известно (может быть измерено вручную). Экспериментальное расстояние D2 между сторонами мишени можно рассчитать по проекции лазерного луча в глобальных координатах. Таким образом, минимизируя разницу между D1 и D2, можно найти зависимую переменную, которая представляет собой расстояние между камерой и лазерной плоскостью. Эта процедура принимает следующий вид:

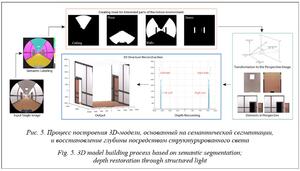

После этого координаты пикселей лазерного луча могут быть повторно спроецированы уравнением (4), но уже с известными параметрами матрицы перехода [Rl|Tl] (рис. 4б). Метод реконструкции помещения После того как система откалибрована, можно переходить к реконструкции структуры внутренней среды помещения. Процесс включает несколько основных этапов (рис. 5). Сначала входное изображение сегментируется на набор интересующих объектов с семантическими сегментами. Затем накладывается маска и извлеченные изображения преобразуются в перспективную проекцию. Данные глубины восстанавливаются на основе лазерного луча. Затем 3D-модель помещения может быть собрана.

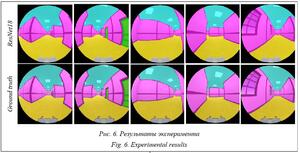

Для обучения нейронной сети при помощи разработанного симулятора было сгенерировано 300 изображений. На обучение отведено 80 %, а 20 % использованы для тестирования. Изображения имели размер 240´240 пикселей. Сеть обучалась с использованием одного процессора.

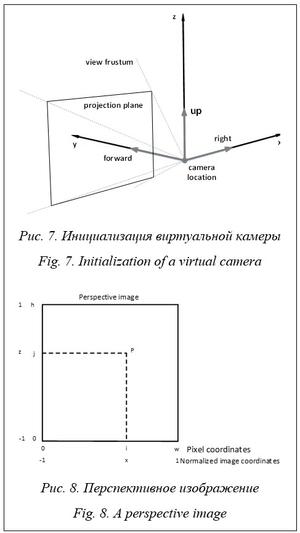

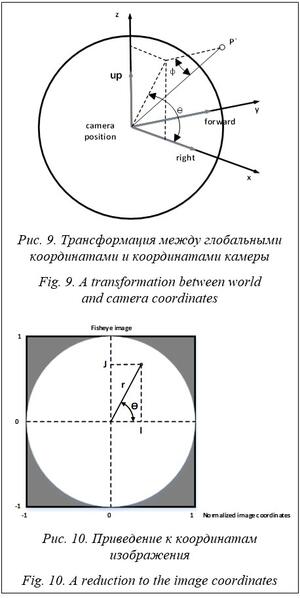

Был описан первый шаг реконструкции помещения. Продемонстрировано, что маркированные изображения, генерируемые предлагаемым симулятором, пригодны для обучения нейронных сетей. Автоматическая маркировка может значительно упростить процесс сбора данных для проверки теорий и результатов экспериментов. Перспективная проекция Процесс создания перспективного изображения происходит в обратном направлении, то есть для каждого пикселя на перспективном изображении необходимо найти наилучшую оценку RGB на изображении, снятом на всенаправленную камеру. Опишем более подробно процесс трансформации. · Инициализируется виртуальная камера, расположенная в начале координат, направленная вниз по оси Y, имеющая горизонтальный и вертикальный углы обзора 90° (рис. 7). · Для каждого пикселя (i, j) в плоскости проекции камеры находится соответствующий 3D-вектор P в глобальных координатах по следующему уравнению (рис. 8):

· Производится поворот вектора P относительно координатных осей для ориентации камеры в требуемом направлении, чему соответствует вектор Р'. · Рассчитываются углы θ и ø (рис. 9):

· Рассчитываются пиксели на всенаправленном изображении (I, J), соответствующие пикселям перспективного изображения (i, j). Учитывая ранее рассчитанные θ и ø, а также линейную зависимость между ø и радиусом r всенаправленного изображения, пиксели (I, J) (рис. 10) можно рассчитать следующим образом:

где fmax – поле зрения объектива «рыбий глаз».

Реконструкция помещения Последний этап связан с 3D-реконструкцией внутренней среды помещения. Для воссоздания сцены с размерами требуется выполнить несколько шагов. В первую очередь извлекаются координаты изображения лазерного луча и вычисляются расстояния до соответствующих стен, а также дверей по уравнению (4). Как только местоположение стены будет известно, можно рассчитать расстояния до пола и потолка. Для этого необходимо определить границу между сегментированными областями на изображении (рис. 5): пол – область между пурпурным и желтым цветами; потолок – область между пурпурным и аквамариновым цветами. Подобно лазерной плоскости расстояния до пола и потолка могут быть рассчитаны с помо-щью триангуляции. Расстояние от мобильного робота до конкретной стены по оси Y известно. Следовательно, координаты вдоль оси Y не изменяются. Зная, что Y = 0, уравнение для вычисления координат стены и потолка можно записать в следующем виде:

С помощью предложенного метода реконструкции можно также восстановить угловую часть. Для этого, во-первых, извлекаются конечные точки лазерного луча. Во-вторых, рассчитывается ориентация в пространстве для каждой стены, а далее угловая стена делится на две части. Наконец, 3D-модель может быть собрана из сегментированных частей в сочетании с соответствующими расстояниями. Отдельные реконструированные 3D-модели, а также глобальная карта (http://www.swsys.ru/uploaded/image/2023-2/2023-2-dop/15.jpg) показывают, что предложенная методика обеспечивает точные и надежные 3D-модели для различных конфигураций внутренних сцен. Очевидно, что с помощью одного входного изображения можно не только реконструировать структуру внутренней среды, но и восстановить соответствующие размеры. Заключение В данной работе рассмотрены новые методы калибровки системы всенаправленного зрения и 3D-реконструкции внутренней среды помещения. Они достаточно просты и требуют только одно входное изображение. Результаты экспериментов показали, что представленный метод калибровки надежен и требует меньше калибровочных шагов по сравнению с другими. Метод реконструкции способен восстановить не только структуру внутренней сцены, но и информацию о глубине. В дальнейших работах планируется исследование переноса возможностей из симулятора в реальный мир. Одним из ключевых преимуществ использования виртуальных сред является их способность представлять разнообразный диапазон реальных условий. Для придания большей динамики планируется расширить возможности текущей версии симулятора за счет добавления пешеходов, создания ручных и автоматизированных систем генерации окружающей среды. Пользователи смогут взаимодействовать со стандартными блоками, представляющими такие элементы, как стены, пол, потолок, мебель или препятствия. Такой подход позволит легко создавать самые разнообразные среды обучения и тестирования. Различия между моделируемыми и реальными сце-нариями могут быть сглажены с помощью нейронных сетей. В статье продемонстрировано, что переход из виртуальных сред в реальные возможен даже без сильного упора на фотореализм. Список литературы 1. Shin J., Yi S. Development of omnidirectional ranging system based on structured light image. J. of Institute of Control, Robotics and Systems, 2012, vol. 18, no. 5, pp. 479–486. doi: 10.5302/J.ICROS.2012.18.5.479. 2. Холодилин И.Ю., Савостеенко Н.В., Нестеров А.С., Киселева А.А., Панов К.Э., Дудкин М.М. Программа по изучению курса компьютерное зрение “iLabit OmViSys”: Свид. о регистр. ПрЭВМ № 2019667285. Рос. Федерация, 2019. 3. Холодилин И.Ю. iLabit OmViSys: фотореалистичный симулятор на базе всенаправленной камеры и структурированного света // Программные продукты и системы. 2021. Т. 34. № 1. С. 157–163. doi: 10.15827/0236-235X.133.157-163. 4. Liu Z., Li X., Li F., Zhang G. Calibration method for line-structured light vision sensor based on a single ball target. Optics and Lasers in Engineering, 2015, vol. 69, pp. 20–28. doi: 10.1016/j.optlaseng.2015.01.008. 5. Wei Z., Shao M., Zhang G., Wang Y. Parallel-based calibration method for line-structured light vision sensor. Optical Engineering, 2014, vol. 53, no. 3, art. 033101. doi: 10.1117/1.OE.53.3.033101. 6. Xu J., Gao B., Liu C., Wang P., Gao S. An omnidirectional 3D sensor with line laser scanning. Optics and Lasers in Engineering, 2016, vol. 84, pp. 96–104. doi: 10.1016/j.optlaseng.2016.04.001. 7. Wang B., Wu M., Jia W. The light plane calibration method of the laser welding vision monitoring system. IOP Conf. Ser.: Mater. Sci. Eng. Proc. ICMES, 2018, vol. 339, art. 012030. doi: 10.1088/1757-899X/339/1/012030. 8. Kurnianggoro L., Hoang V., Jo K. Calibration of a 2D laser scanner system and rotating platform using a point-plane constraint. Comput. Sci. and Inform. Sys., 2015, vol. 12, no. 1, pp. 307–322. doi: 10.2298/CSIS141020093K. 9. Nakagawa M., Yamamoto T., Tanaka S., Shiozaki M., Ohhashi T. Topological 3D modeling using indoor mobile lidar data. ISPRS, 2015, vol. XL-4/W5, pp. 13–18. doi: 10.5194/isprsarchives-XL-4-W5-13-2015. 10. Li X., Li S., Jia S., Xu C. Mobile robot map building based on laser ranging and kinect. Proc. IEEE ICIA, 2016, pp. 819–824. doi: 10.1109/ICInfA.2016.7831932. 11. Tsai F., Wu T., Lee I., Chang H., Su A. Reconstruction of indoor models using point clouds generated from single-lens reflex cameras and depth images. ISPRS, 2015, vol. XL-4/W5, pp. 99–102. doi: 10.5194/isprsarchives-XL-4-W5-99-2015. 12. Fujita T. 3D sensing and mapping for a tracked mobile robot with a movable laser ranger finder. Int. J. Mech. Mechatron. Eng., 2012, vol. 6, no. 2, pp. 501–506. 13. Qin H., Bi Y., Lin F., Zhang Y.F., Chen B.M. A 3D rotating laser based navigation solution for micro aerial vehicles in dynamic environments. Unmanned Syst., 2018, vol. 6, no. 4, pp. 297–305. doi: 10.1142/S2301385018500103. 14. Son Y., Yoon S., Oh S., Han S. A lightweight and cost-effective 3D omnidirectional depth sensor based on laser triangulation. IEEE Access, 2019, vol. 7, pp. 58740–58750. doi: 10.1109/ACCESS.2019.2914220. 15. Ruvo P., Ruvo G., Distante A., Nitti M., Stella E., Marino F. An omnidirectional range sensor for environmental 3-D reconstruction. Proc. IEEE ISIE, 2010, pp. 396–401. doi: 10.1109/ISIE.2010.5637870. 16. Fernandez-Labrador C., Perez-Yus A., Lopez-Nicolas G., Guerrero J. Layouts from panoramic images with geometry and deep learning. IEEE Robotics and Automation Letters, 2018, vol. 3, no. 4, pp. 3153–3160. doi: 10.1109/LRA.2018.2850532. 17. Fernandez-Labrador C., Facil J., Perez-Yus A., Demonceaux C., Civera J., Guerrero J. Corners for layout: End-to-end layout recovery from 360 images. IEEE Robotics and Automation Letters, 2020, vol. 5, no. 2, pp. 1255–1262. doi: 10.1109/LRA.2020.2967274. 18. Scaramuzza D., Martinelli A., Siegwart R. A flexible technique for accurate omnidirectional camera calibration and structuredfrom motion. Proc. IEEE ICVS, 2006, pp. 45–45. doi: 10.1109/ICVS.2006.3. 19. He K., Zhang X., Ren S., Sun J. Deep residual learning for image recognition. Proc. IEEE Conf. CVPR, 2016, pp. 770–778. doi: 10.1109/CVPR.2016.90. Reference List 1. Shin, J., Yi, S. (2012) ‘Development of omnidirectional ranging system based on structured light image’, J. of Institute of Control, Robotics and Systems, 18(5), pp. 479–486. doi: 10.5302/J.ICROS.2012.18.5.479. 2. Kholodilin, I.Yu., Savosteenko, N.V., Nesterov, A.S., Kiseleva, A.A., Panov, K.E., Dudkin, M.M. (2019) Program for Studying the Course Computer Vision “iLabit OmViSys”, Pat. RF, № 2019667285. 3. Kholodilin, I.Yu. (2021) ‘iLabit OmViSys: A photorealistic simulator based on the omnidirectional camera and structured light’, Software & Systems, 34(1), pp. 157–163. doi: 10.15827/0236-235X.133.157-163 (in Russ.). 4. Liu, Z., Li, X., Li, F., Zhang, G. (2015) ‘Calibration method for line-structured light vision sensor based on a single ball target’, Optics and Lasers in Engineering, 69, pp. 20–28. doi: 10.1016/j.optlaseng.2015.01.008. 5. Wei, Z., Shao, M., Zhang, G., Wang, Y. (2014) ‘Parallel-based calibration method for line-structured light vision sensor’, Optical Engineering, 53(3), art. 033101. doi: 10.1117/1.OE.53.3.033101. 6. Xu, J., Gao, B., Liu, C., Wang, P., Gao, S. (2016) ‘An omnidirectional 3D sensor with line laser scanning’, Optics and Lasers in Engineering, 84, pp. 96–104. doi: 10.1016/j.optlaseng.2016.04.001. 7. Wang, B., Wu, M., Jia, W. (2018) ‘The light plane calibration method of the laser welding vision monitoring system’, IOP Conf. Ser.: Mater. Sci. Eng. Proc. ICMES, 339, art. 012030. doi: 10.1088/1757-899X/339/1/012030. 8. Kurnianggoro, L., Hoang, V., Jo, K. (2015) ‘Calibration of a 2D laser scanner system and rotating platform using a point-plane constraint’, Comput. Sci. and Inform. Sys., 12(1), pp. 307–322. doi: 10.2298/CSIS141020093K. 9. Nakagawa, M., Yamamoto, T., Tanaka, S., Shiozaki, M., Ohhashi, T. (2015) ‘Topological 3D modeling using indoor mobile lidar data’, ISPRS, XL-4/W5, pp. 13–18. doi: 10.5194/isprsarchives-XL-4-W5-13-2015. 10. Li, X., Li, S., Jia, S., Xu, C. (2016) ‘Mobile robot map building based on laser ranging and kinect’, Proc. IEEE ICIA, pp. 819–824. doi: 10.1109/ICInfA.2016.7831932. 11. Tsai, F., Wu, T., Lee, I., Chang, H., Su, A. (2015) ‘Reconstruction of indoor models using point clouds generated from single-lens reflex cameras and depth images’, ISPRS, XL-4/W5, pp. 99–102. doi: 10.5194/isprsarchives-XL-4-W5-99-2015. 12. Fujita, T. (2012) ‘3D sensing and mapping for a tracked mobile robot with a movable laser ranger finder’, Int. J. Mech. Mechatron. Eng., 6(2), pp. 501–506. 13. Qin, H., Bi, Y., Lin, F., Zhang, Y.F., Chen, B.M. (2018) ‘A 3D rotating laser based navigation solution for micro aerial vehicles in dynamic environments’, Unmanned Syst., 6(4), pp. 297–305. doi: 10.1142/S2301385018500103. 14. Son, Y., Yoon, S., Oh, S., Han, S. (2019) ‘A lightweight and cost-effective 3D omnidirectional depth sensor based on laser triangulation’, IEEE Access, 7, pp. 58740–58750. doi: 10.1109/ACCESS.2019.2914220. 15. Ruvo, P., Ruvo, G., Distante, A., Nitti, M., Stella, E., Marino, F. (2010) ‘An omnidirectional range sensor for environmental 3-D reconstruction’, Proc. IEEE ISIE, pp. 396–401. doi: 10.1109/ISIE.2010.5637870. 16. Fernandez-Labrador, C., Perez-Yus, A., Lopez-Nicolas, G., Guerrero, J. (2018) ‘Layouts from panoramic images with geometry and deep learning’, IEEE Robotics and Automation Letters, 3(4), pp. 3153–3160. doi: 10.1109/LRA.2018.2850532. 17. Fernandez-Labrador, C., Facil, J., Perez-Yus, A., Demonceaux, C., Civera, J., Guerrero, J. (2020) ‘Corners for layout: End-to-end layout recovery from 360 images’, IEEE Robotics and Automation Letters, 5(2), pp. 1255–1262. doi: 10.1109/LRA.2020.2967274. 18. Scaramuzza, D., Martinelli, A., Siegwart, R. (2006) ‘A flexible technique for accurate omnidirectional camera calibration and structuredfrom motion’, Proc. IEEE ICVS, pp. 45–45. doi: 10.1109/ICVS.2006.3. 19. He, K., Zhang, X., Ren, S., Sun, J. (2016) ‘Deep residual learning for image recognition’, Proc. IEEE Conf. CVPR, |

| Permanent link: http://swsys.ru/index.php?page=article&id=5004&lang=&lang=en&like=1 |

Print version |

| The article was published in issue no. № 2, 2023 [ pp. 293-302 ] |

Perhaps, you might be interested in the following articles of similar topics:

(1)

(1) (4)

(4) (5)

(5)

(6)

(6) (7)

(7) (8)

(8)

(9)

(9) (10)

(10) (11)

(11)

(13)

(13)

(15)

(15)